DaaS et Intelligence en Continu dans l’Industrie 4.0 : Vers une nouvelle ère de la production intelligente

Introduction

L’industrie est au cœur d’enjeux économiques et climatiques majeurs qui amènent à revoir fondamentalement ses activités de production. Pour relever ces défis, la data et l’intelligence artificielle (IA) transforment les usines, les modes de production et de distribution. Elles ouvrent un monde d’opportunités et recèlent un potentiel immense dans toutes les dimensions industrielles. À la clé, l’usine intelligente, capable de piloter de façon agile sa performance tout en réduisant son empreinte carbone. Dans ce sujet, nous aborderons la manière dont le Big Data as a Service (synergie entre Cloud et Big Data) et l’Intelligence en Continu (IA en temps réel) transforment les processus de production dans l’Industrie 4.0. Nous mettrons en lumière les effets transformateurs de ces technologies sur la fabrication, y compris l’automatisation, la maintenance prédictive, et l’analyse en temps réel.

Tansformation Numérique dans l’Industrie 4.0

L’Industrie 4.0 désigne la quatrième révolution industrielle, qui repose sur la numérisation et l’interconnexion des systèmes de production. Elle implique l’utilisation de technologies telles que les capteurs intelligents, l’internet industriel des objets (IIoT), le cloud computing, le big data, l’IA, le machine learning, la robotique, la réalité augmentée ou encore les jumeaux numériques. Ces technologies permettent de collecter, stocker, analyser et exploiter des données massives provenant des machines, des produits, des clients ou de l’environnement. Elles offrent ainsi une vision globale et en temps réel de la chaîne de valeur industrielle, depuis la conception jusqu’à la distribution. Elles favorisent également l’adaptation rapide aux besoins du marché, l’optimisation des ressources, la personnalisation des produits et services, et l’amélioration de la qualité et de la sécurité.

Selon une étude de Statista, le marché mondial de l’Industrie 4.0 devrait atteindre 156 milliards de dollars en 2024, contre 71 milliards en 2019. Les secteurs les plus concernés sont ceux de l’automobile, de l’aéronautique, de la chimie, du pétrole et du gaz, ou encore de la santé.

Global Lighthouse Network :

Le Global Lighthouse Network (GLN), initié par le Forum économique mondial, représente un phare pour la transformation numérique dans le monde manufacturier. Il réunit 132 sites de production exemplaires qui ont brillamment intégré les technologies de l’Industrie 4.0, servant de modèles d’efficacité, de durabilité et de résilience. Ces “phares” illustrent l’utilisation stratégique du cloud, de l’IA, de la robotique, et d’autres innovations de la quatrième révolution industrielle pour révolutionner les opérations industrielles.

Les membres du GLN, issus de divers secteurs allant de l’automobile à la santé, démontrent les avantages comparatifs significatifs de l’adoption des technologies 4IR, avec une amélioration de 20% de leurs réseaux de production. Ils soulignent l’importance de l’alignement stratégique avec les objectifs commerciaux, une conscience aiguisée pour une stratégie optimale et mettent en avant les personnes et l’engagement des employés comme facteurs clés de succès.

La stratégie de “Suiveur Intelligent” est encouragée, incitant les entreprises à s’inspirer des cas d’utilisation et des méthodologies éprouvées par le GLN pour propulser leur propre transformation numérique. Le tableau des cas d’utilisation résume les succès remarquables des membres du GLN, comme ASE – Kaohsiung dans les semi-conducteurs et Johnson & Johnson dans la santé, qui ont utilisé l’IA et d’autres technologies pour améliorer la production et l’efficacité, contribuant ainsi à une croissance durable et responsable.

Data as a Service (DaaS) et Agilité des Données

Le DaaS est un modèle qui consiste à fournir des données à la demande aux utilisateurs finaux via le cloud. Il s’agit d’une forme de cloud computing qui permet d’accéder à des données provenant de sources variées, internes ou externes à l’entreprise, sans avoir à se soucier des aspects techniques liés au stockage, au traitement ou à la sécurité des données. Le DaaS offre ainsi aux utilisateurs une plus grande flexibilité, une meilleure qualité et une réduction des coûts.

Le DaaS est particulièrement adapté aux besoins de l’Industrie 4.0, qui requiert une agilité des données pour faire face aux changements rapides du marché et aux exigences croissantes des clients. En effet, le DaaS permet aux industriels de :

- Accéder à des données pertinentes et actualisées pour prendre des décisions éclairées

- Intégrer facilement des données provenant de différentes sources, telles que les capteurs intelligents, les machines connectées ou les plateformes externes

- Exploiter les données à travers des outils d’analyse avancée ou d’IA pour optimiser les processus de production

- Partager les données avec les partenaires ou les clients pour améliorer la collaboration et la satisfaction

Quelques avantages généraux que le DaaS pourrait apporter dans de tels environnements de fabrication avancée :

- · Analyse de Données Améliorée et Prise de Décision : Le DaaS peut offrir des capacités avancées d’analyse de données, permettant à ces entreprises de prendre des décisions plus éclairées basées sur des données en temps réel. Ceci est crucial dans des environnements de fabrication complexes où l’optimisation des processus et la réactivité rapide aux changements peuvent avoir un impact significatif sur l’efficacité et la productivité.

- · Scalabilité et Flexibilité : Le DaaS offre des capacités évolutives de stockage et de traitement de données, permettant à des entreprises comme ASE, Flex et Midea d’ajuster leur infrastructure de données en fonction de leurs besoins actuels sans investissement capital important dans des centres de données physiques.

- · Intégration et Accessibilité Améliorées : Avec le DaaS, les données de diverses sources (comme les capteurs et les dispositifs IoT) peuvent être intégrées plus efficacement, fournissant une vue unifiée des opérations. Ceci est particulièrement important pour les entreprises gérant des processus de fabrication à grande échelle et complexes avec de nombreux points de données.

- · Rentabilité : En utilisant le DaaS, ces entreprises peuvent potentiellement réduire les coûts associés à la gestion des données, car cela élimine le besoin de maintenir une infrastructure de stockage de données en interne et du personnel associé.

- · Sécurité et Conformité Améliorées : Les fournisseurs de DaaS offrent souvent des mesures de sécurité robustes et se conforment aux réglementations pertinentes en matière de protection des données, ce qui est essentiel pour les entreprises manipulant des données sensibles ou propriétaires.

Selon une étude d’EY, le DaaS est un facteur clé pour accélérer la transformation digitale dans l’industrie. Il permet notamment d’améliorer la productivité (+30%), la rentabilité (+20%) et la compétitivité (+15%).

Intelligence en Continu et Prise de Décision en Temps Réel

L’intelligence en continu est un concept qui désigne la capacité à analyser et à exploiter des données en temps réel pour prendre des décisions et agir de manière optimale. Elle repose sur l’utilisation de technologies d’IA, de machine learning, de streaming analytics ou encore d’edge computing. Elle permet de traiter des flux de données massifs et complexes, provenant de sources diverses et variées, telles que les capteurs intelligents, les machines connectées, les réseaux sociaux ou les applications mobiles.

L’intelligence en continu est un atout majeur pour l’Industrie 4.0, qui nécessite une réactivité et une adaptabilité accrues face aux fluctuations du marché et aux demandes des clients. En effet, l’intelligence en continu permet aux industriels de :

- Détecter et anticiper les anomalies, les pannes ou les risques dans les processus de production

- Adapter en temps réel les paramètres de fonctionnement des machines ou des robots

- Optimiser la gestion des stocks, des flux logistiques ou de la consommation énergétique

- Personnaliser les produits ou les services en fonction des besoins ou des préférences des clients

- Innover et créer de nouveaux modèles d’affaires basés sur les données

Selon une étude de Forbes, l’intelligence en continu est un facteur clé pour accroître la performance et la compétitivité dans l’industrie. Elle permet notamment d’augmenter la productivité (+40%), la qualité (+37%) et la satisfaction client (+34%).

Exemples:

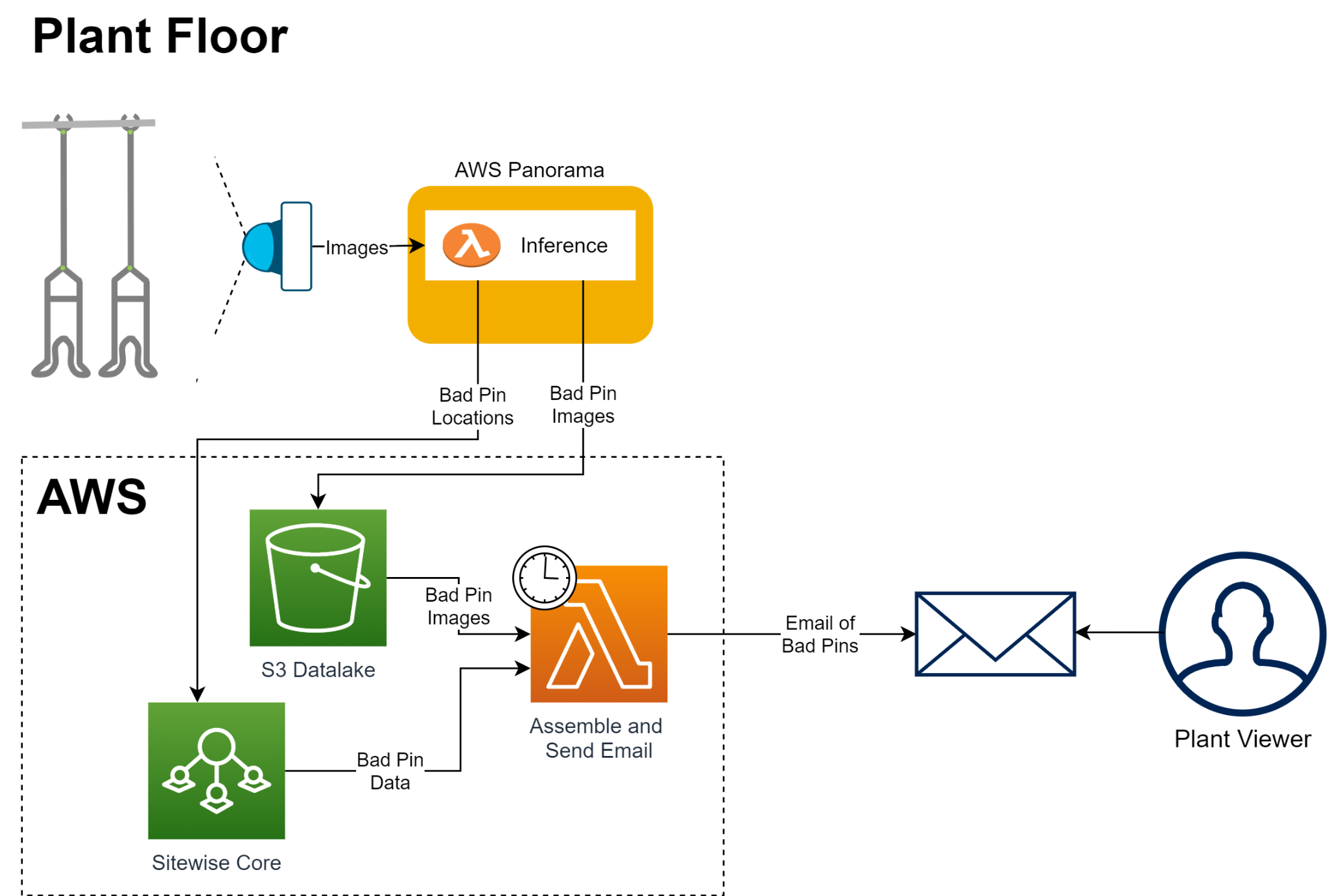

Tyson Foods a intégré une solution de détection d’anomalies basée sur la vision par ordinateur pour la maintenance prédictive de ses équipements industriels. Utilisant Amazon Lookout for Vision et AWS Panorama, Tyson a automatisé l’inspection de porte-produits pendant la production, identifiant des défaillances potentielles pour éviter des risques pour la sécurité et la qualité du produit. Les modèles de vision par ordinateur effectuent des inférences pour détecter les anomalies, et les résultats sont envoyés dans le cloud pour un traitement supplémentaire. Cette innovation a permis d’économiser environ une heure de travail par jour et par ligne de production, réduisant le temps de développement de 12% grâce à l’utilisation de services gérés AWS et à des modèles de développement répétable.

Dans le secteur automobile, l’optimisation du cycle de vie des logiciels et l’accélération des boucles de rétroaction numérique sont essentielles, surtout avec l’augmentation de l’automatisation des véhicules. Azure offre une palette de services qui supportent l’analyse de données pour les flottes de véhicules de test. Azure IoT Hub capte les données de télémétrie en temps réel lors des essais sur route. Ces données sont ensuite acheminées vers Azure Event Hubs, qui agit comme un pipeline de données haute capacité, avant d’être stockées dans Azure Blob Storage. Azure Data Explorer permet l’exploration et l’analyse approfondie de ces vastes volumes de données. Avec Azure Functions, les OEM automobiles peuvent créer des flux de travail automatisés pour traiter et analyser les données, permettant ainsi aux ingénieurs R&D d’accéder presque en temps réel aux diagnostics des tests de conduite. Cette architecture contribue à réduire le temps entre la collecte des données de test et leur utilisation par les équipes de R&D, favorisant ainsi des cycles de développement plus courts et une collaboration sécurisée entre les OEM et leurs fournisseurs.

- End-to-end computer vision at the edge for manufacturing:

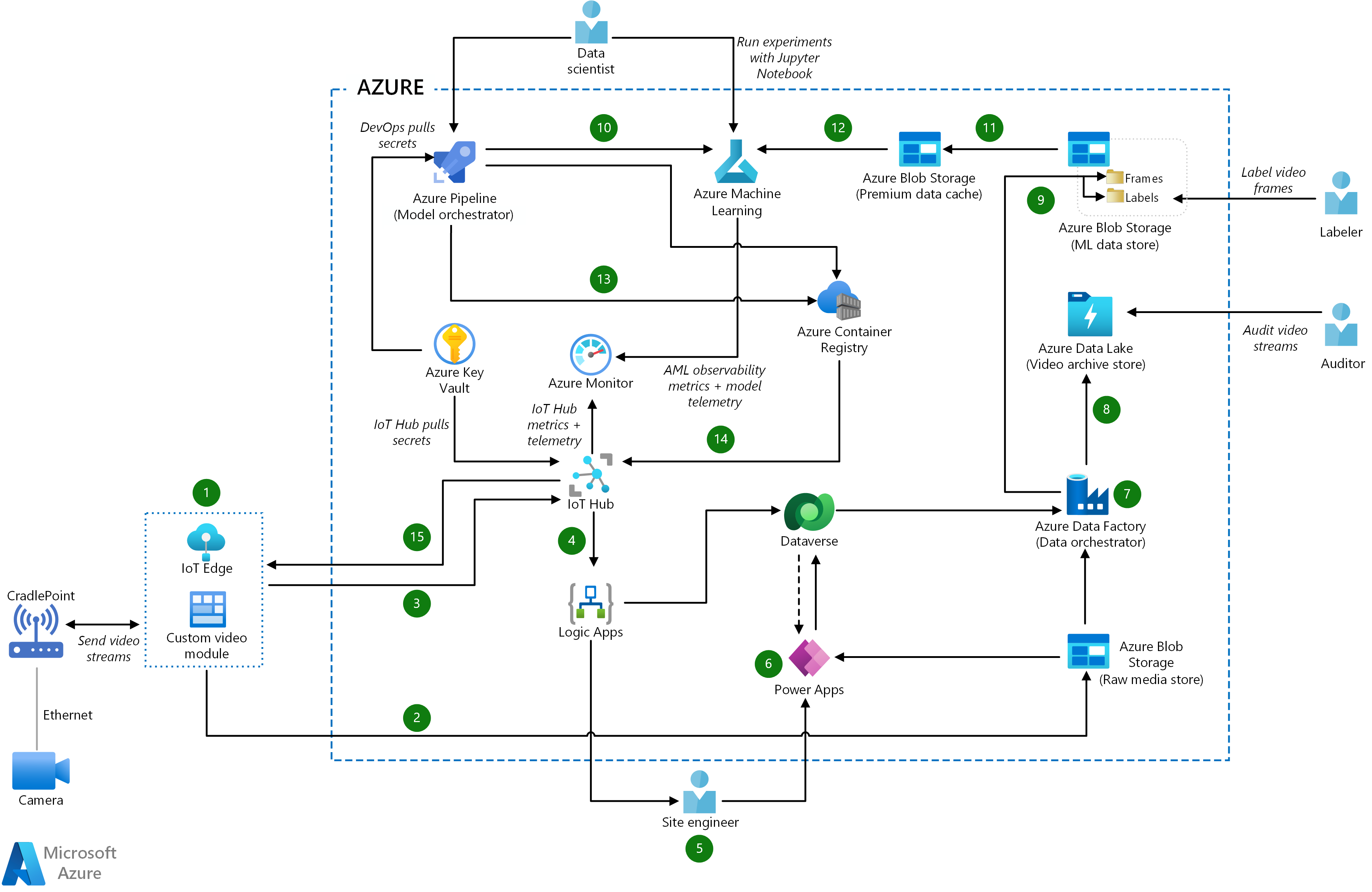

Cet exemple illustre une approche de l’intelligence continue au sein d’un environnement manufacturier en utilisant des technologies de pointe de l’Internet des Objets (IoT) et de vision par ordinateur. À partir de flux vidéo capturés en temps réel par des caméras sur le site de production, les dispositifs IoT Edge traitent les données à la périphérie du réseau pour une réponse rapide et une réduction de la latence. Ces données traitées sont ensuite orchestrées à travers Azure IoT Hub, qui agit comme un pivot central, permettant l’intégration et l’automatisation des flux de travail via Logic Apps. La sécurisation et la gestion des secrets sont assurées par Azure Key Vault, tandis que Azure Pipeline orchestre le déploiement des modèles d’apprentissage machine créés et affinés par les scientifiques de données dans Azure Machine Learning. Avec l’ajout de Power Apps, les utilisateurs finaux peuvent interagir de manière personnalisée avec les insights tirés des données, ce qui facilite la prise de décisions éclairées et l’adaptation rapide aux conditions de production en constante évolution. Cette architecture montre comment l’intégration harmonieuse de l’IoT, du cloud et de l’intelligence artificielle permet d’atteindre une intelligence opérationnelle continue, essentielle pour l’optimisation et l’innovation dans le secteur manufacturier moderne.

How to design data mesh architecture with Microsoft Fabric

Data mesh is a new paradigm for data management that aims to address the challenges of scaling data analytics in large and complex organizations. Data mesh shifts from a centralized, monolithic data platform to a decentralized, domain-oriented data architecture, where each business domain owns and exposes its own data as a product.

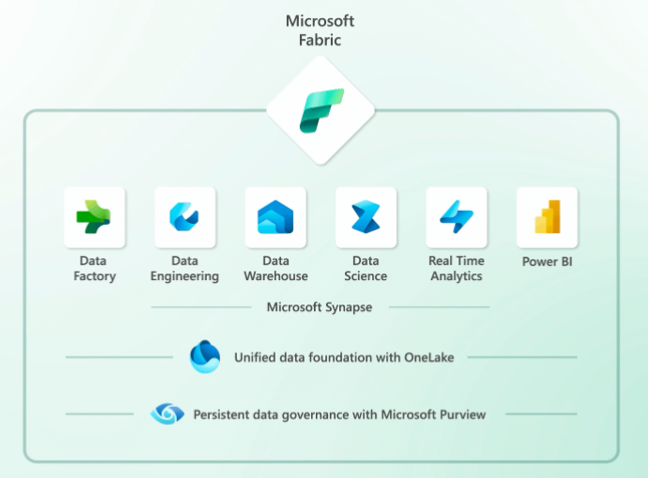

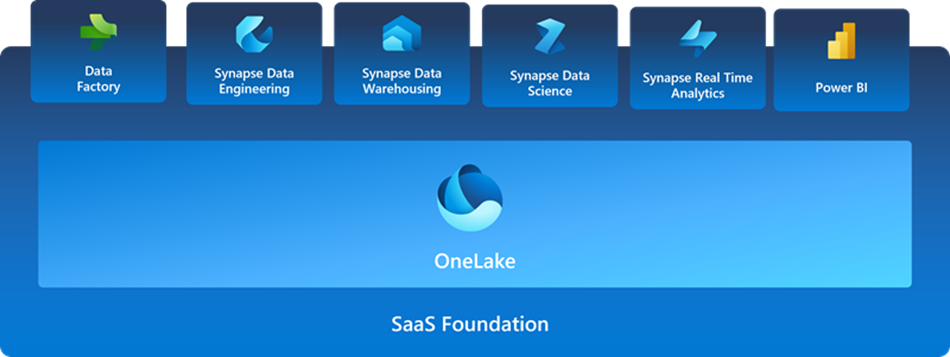

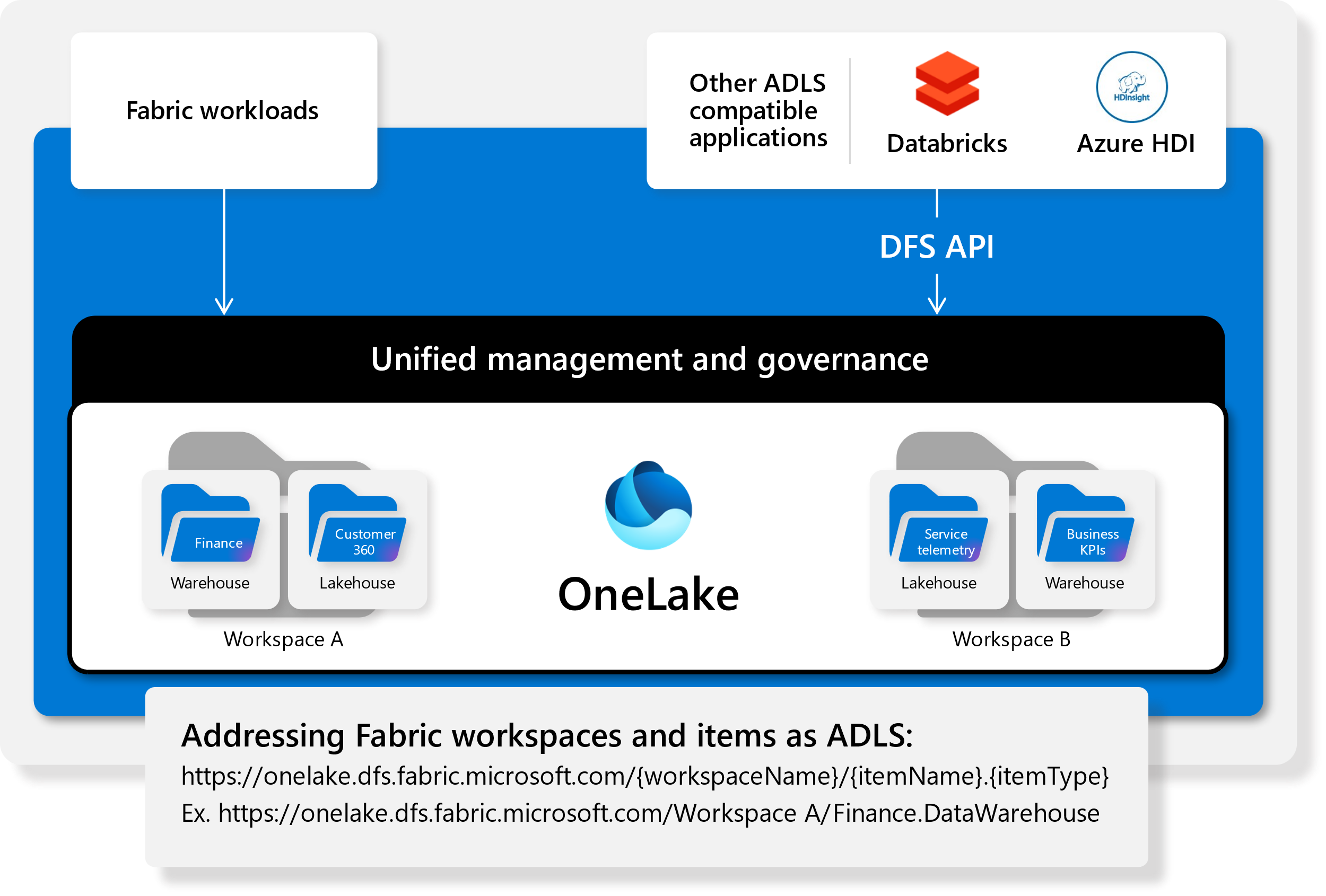

Microsoft Fabric is an all-in-one analytics solution that enables enterprises to implement data mesh architecture with ease and efficiency. Microsoft Fabric provides a comprehensive suite of services, including data lake, data engineering, data integration, data science, real-time analytics, and business intelligence, all in one place. With Microsoft Fabric, you can enjoy a highly integrated, end-to-end, and easy-to-use product that simplifies your analytics needs.

In this blog post, we will show you how to design data mesh architecture with Microsoft Fabric in four steps:

- Define your business domains and identify their data products. A business domain is a logical grouping of related business activities, such as marketing, sales, human resources, etc. A data product is a self-contained, discoverable, and accessible unit of data that provides value to its consumers. For example, a marketing domain may have data products such as customer segments, campaign performance, or web analytics.

- Organize your data into domains using Microsoft Fabric’s Domains feature. Domains are a way to categorize and filter your data assets by business domain in Microsoft Fabric. You can create domains for each of your business domains and assign them to your data assets, such as datasets, notebooks, pipelines, dashboards, etc. This way, you can easily find and access the data products that belong to each domain.

- Enable data sharing and discovery across domains using Microsoft Fabric’s OneLake and Purview features. OneLake is a unified data lake that allows you to store and access all your data in one place using your preferred analytics tools. Purview is a data governance service that helps you catalog, classify, and monitor your data across Microsoft Fabric and other sources. With OneLake and Purview, you can enable data sharing and discovery across domains by creating a common metadata layer that describes your data products and their lineage, quality, sensitivity, and usage.

- Build and consume your data products using Microsoft Fabric’s analytics experiences. Microsoft Fabric offers a range of analytics experiences tailored to different personas and tasks, such as Data Engineering, Data Science, Data Warehouse, Real-Time Analytics, and Power BI. You can use these experiences to build and consume your data products using the best tools for the job. For example, you can use Data Engineering to perform large-scale data transformation using Spark, Data Science to create machine learning models using Python or R, Data Warehouse to run SQL queries on your relational data, Real-Time Analytics to process streaming data using Azure Data Explorer or Azure Stream Analytics, and Power BI to create interactive dashboards and reports.

By following these steps, you can design data mesh architecture with Microsoft Fabric and leverage its benefits of scalability, agility, autonomy, and quality for your data analytics.

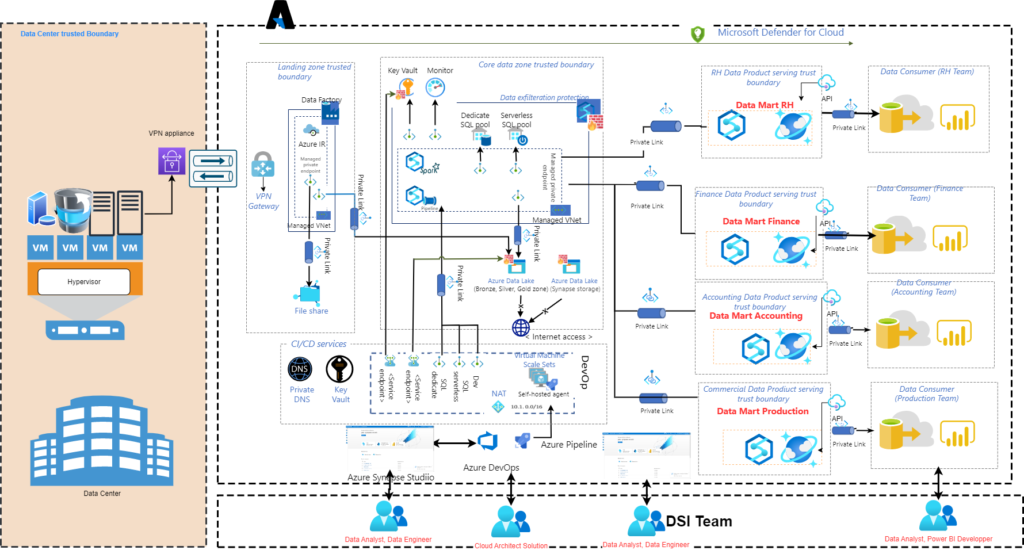

Data Mesh: A Modern Approach to Data Management with Azure Technologies

In today’s digital world, data is one of the most valuable assets of an organization. However, as the volume and complexity of data continues to grow, managing data effectively has become a major challenge for many organizations. This is where the concept of Data Mesh comes in.

Zhamak Dehghani first introduced the concept of a Data Mesh in 2019 as a way to address the challenges that arise from the growing volume and complexity of data in modern enterprises. The main idea behind Data Mesh is to shift the focus of data management from centralized, IT-led control to decentralized, domain-driven ownership.

In a Data Mesh architecture, data is treated as a first-class citizen and is managed as a product, with ownership and control distributed across domain-specific teams. This approach empowers teams to have full autonomy over their data, allowing them to make decisions about how to store, manage, and use their data in a way that best fits their needs.

A key aspect of Data Mesh is the use of APIs and microservices to provide a self-service model for accessing and using data. Teams can discover and use data services and APIs provided by other teams, and can also expose their own data services and APIs to others. This enables a more efficient and flexible flow of data across the organization, and encourages teams to collaborate and share data in a consistent and secure manner.

Overall, Data Mesh is a modern approach to data management that helps organizations to effectively manage the growing volume and complexity of data, and to drive innovation and value from their data assets.

Data Mesh is a software architecture pattern that provides a new way of thinking about data and its management. This pattern emphasizes on data as a first-class citizen and aims to promote decentralized ownership and management of data across an organization. With the rise of cloud computing, organizations are increasingly relying on cloud-based data services to support their data management needs. In this blog, we’ll explore how Microsoft Azure Data Services can be used to implement a Data Mesh architecture.

https://www.linkedin.com/embeds/publishingEmbed.html?articleId=7311556257037078719&li_theme=light

Microsoft Azure Services provides a comprehensive set of data management and analytics services that can be used to build scalable and robust data pipelines, manage large datasets, and analyze data to gain valuable insights. These services include Azure Cosmos DB, Azure Data Lake Storage, Azure Databricks, and Azure SQL Database, among others.

One of the key principles of Data Mesh is to have decentralized teams own and manage their data, which can be easily achieved using Azure Data Services. With Azure Cosmos DB, for example, teams can create and manage their own NoSQL databases with full autonomy, allowing them to control the structure, security, and performance of their data. Teams can also use Azure Data Lake Storage to store and manage their large datasets, and Azure Databricks to perform complex data processing and analysis.

In addition to decentralized data ownership, Data Mesh also emphasizes on data discovery and discovery of data services. Azure Data Services provides a number of tools and services that can be used to discover and manage data assets across an organization. For example, Azure Data Catalog can be used to catalog, discover, and manage data assets, while Azure API Management can be used to manage and discover APIs that expose data assets.

Another important aspect of Data Mesh is the focus on data privacy and security. Azure Data Services provides a number of security features that can be used to ensure that sensitive data is protected, including encryption at rest and in transit, role-based access control, and threat detection. Teams can also take advantage of Azure Active Directory to manage access to data assets and enforce security policies.

Microsoft Azure provides a range of technologies and services that can be used to build a Data Mesh architecture. Here are some of the key Azure services and technologies that can help organizations implement a Data Mesh platform:

- Azure Cosmos DB: This is a globally distributed, multi-model database service that provides low latency and high throughput. It allows teams to store and manage data in a variety of formats, including NoSQL and graph databases, and provides a range of APIs for accessing data.

- Azure Functions: This is a serverless computing platform that allows teams to run small pieces of code (functions) in response to events. It can be used to build microservices that provide access to data and perform actions such as data validation, enrichment, and transformation.

- Azure API Management: This is a service for managing APIs, including creating, publishing, and managing APIs, and monitoring their usage. It can be used to provide a consistent and secure way for teams to access and use data from APIs exposed by other teams.

- Azure DevOps: This is a platform for developing and delivering software, including continuous integration and continuous delivery (CI/CD) pipelines. It can be used to manage the lifecycle of Data Mesh microservices and APIs, including their deployment, testing, and monitoring.

- Azure Event Grid: This is an event routing service that allows teams to process and react to events in near-real time. It can be used to implement event-driven architectures and decouple data processing from data storage, making it easier for teams to build and maintain data pipelines.

- Azure Stream Analytics: This is a real-time data stream processing service that allows teams to analyze and process large amounts of data in real-time. It can be used to perform actions such as data validation, enrichment, and transformation, and to route data to other Azure services for storage or further processing.

- Azure Data Factory: This is a data integration service that allows teams to create and manage data pipelines. It can be used to move data between different Azure services, such as Cosmos DB and Stream Analytics, and to perform data transformations and aggregations.

- Azure Synapse Analytics (formerly SQL Data Warehouse): This is a big data analytics service that allows teams to analyze large amounts of structured and unstructured data using a combination of on-demand and provisioned resources. It provides a seamless experience between big data and data warehousing, enabling teams to build and maintain data pipelines and perform complex data analyses with ease.

- Azure Databricks: This is a fast, easy, and collaborative Apache Spark-based analytics platform that allows teams to process and analyze large amounts of data. It provides a range of machine learning and graph processing capabilities, and integrates seamlessly with other Azure services such as Cosmos DB, Event Grid, and Stream Analytics.

- Azure Data Lake Storage: This is a scalable and secure data lake that allows teams to store and manage large amounts of data, both structured and unstructured. It provides a range of features for data management, such as data access control, data encryption, and data archiving, and integrates seamlessly with other Azure services such as Synapse Analytics and Databricks.

- Azure Purview: This is a data catalog and discovery service that helps organizations discover, understand, and govern their data assets, both on-premises and in the cloud. It provides a unified view of data assets across an organization, enabling teams to discover, understand, and manage data assets, and to improve data quality and consistency across the organization. By using Azure Purview, organizations can establish a comprehensive data catalog that supports their Data Mesh architecture, enabling them to effectively manage and extract value from their data assets.

- Power BI: This is a business intelligence and data visualization tool that allows teams to connect, visualize, and share data insights. It provides a range of features for data exploration and analysis, such as interactive reports and dashboards, and integrates seamlessly with other Azure services such as Synapse Analytics, Databricks, and Data Lake Storage.

- Azure Data Catalog: This is a data discovery and metadata management service that allows teams to catalog, discover, and understand data assets. It provides a centralized repository for metadata, enabling teams to discover, understand, and share data assets, and to improve data quality and consistency across the organization.

- Power Automate: This is a low-code automation platform that allows teams to automate repetitive manual tasks and business processes. It integrates seamlessly with other Azure services, such as Event Grid and Stream Analytics, enabling teams to build and maintain data pipelines and to automate data-driven workflows.

- Azure Active Directory (AD): This is a comprehensive identity and access management solution that helps secure access to resources and data. It integrates with other Azure services, such as Azure Synapse Analytics and Databricks, to provide single sign-on and secure access control.

- Azure Key Vault: This is a secure key management service that helps organizations protect and manage their cryptographic keys and secrets. It integrates with other Azure services, such as Azure Synapse Analytics and Databricks, to provide secure storage and management of secrets used by applications and services.

- Azure Policy: This is a policy enforcement service that helps organizations manage and enforce compliance policies across their Azure resources. It provides a unified policy definition and enforcement mechanism, enabling organizations to enforce policies such as data protection and data privacy policies, and to ensure that data is governed consistently across the enterprise.

- Azure Information Protection: This is a data classification and protection service that helps organizations classify and protect sensitive data, both on-premises and in the cloud. It provides a range of capabilities for data classification, labeling, and protection, enabling organizations to ensure that sensitive data is protected and governed consistently across the enterprise.

By using these and other Azure services, organizations can build a Data Mesh architecture that enables them to manage their data effectively and drive value from their data assets. Teams can access and use data in a self-serve manner, and collaborate and share data in a consistent and secure manner.

In conclusion, Data Mesh is a modern approach to data management that can help organizations to effectively manage the growing volume and complexity of data and to drive innovation and value from their data assets. Microsoft Azure provides a range of technologies and services that can be used to build a Data Mesh architecture, enabling organizations to take full advantage of the benefits of this approach.

Introducing Microsoft Fabric: Data analytics for the era of AI

If you are looking for a data analytics platform that can handle all your data needs, from ingestion to visualization, you might be wondering how Microsoft Fabric compares to Power BI and Synapse Analytics Studio. In this blog post, we will explore the similarities and differences between these three products and help you decide which one is best for your scenario.

Microsoft Fabric is a new end-to-end, unified analytics platform that integrates technologies like Azure Data Factory, Azure Synapse Analytics, and Power BI into a single product. Fabric provides a seamless experience for data engineers, data warehousing professionals, data scientists, data analysts, and business users to work with data and generate insights. Fabric also leverages generative AI and language model services, such as Azure OpenAI Service, to create personalized and natural AI experiences.

Power BI is a business intelligence tool that enables users to connect to various data sources, transform and model data, create interactive reports and dashboards, and share insights with others. Power BI also offers advanced analytics capabilities, such as AI visualizations, Q&A, and automated machine learning.

Synapse Analytics Studio is a web-based interface that allows users to access various Azure data services, such as Azure Data Lake Storage Gen2, Azure SQL Database, Azure Cosmos DB, Azure Data Factory, Azure Synapse Analytics, and Azure Machine Learning. Synapse Analytics Studio enables users to perform data engineering, data exploration, data warehousing, big data analytics, and machine learning tasks using a unified workspace.

All three products are part of the Microsoft data platform and can work together to deliver powerful analytics solutions. However, they also have some key differences that make them suitable for different use cases. Here are some of the main factors to consider when choosing between them:

- Data sources: Fabric can connect to any data source that Power BI or Synapse Analytics Studio can connect to, as well as additional sources such as Azure OpenAI Service. Fabric also supports real-time streaming data ingestion and processing using Synapse Real-Time Analytics.

- Data integration: Fabric provides a built-in data integration service that simplifies the process of ingesting, transforming, and preparing data for analysis. Power BI also has a data integration service called Power Query that can perform similar tasks. Synapse Analytics Studio relies on Azure Data Factory for data integration workflows.

- Data modeling: Fabric allows users to create semantic models using Power BI Desktop or Excel and publish them to the Fabric cloud service. Power BI also supports semantic modeling using Power BI Desktop or Excel. Synapse Analytics Studio does not have a dedicated data modeling service but can use SQL Server Analysis Services or Azure Analysis Services for this purpose.

- Data analysis: Fabric offers a rich set of tools for data analysis, such as SQL queries, notebooks (Python, Scala, Spark SQL), Power BI reports and dashboards, AI visualizations, Q&A, automated machine learning, and Copilot (a natural language interface for querying data). Power BI also provides many of these tools but does not support notebooks or Copilot. Synapse Analytics Studio supports SQL queries and notebooks but does not have native support for Power BI or AI visualizations.

- Data visualization: Fabric enables users to create and consume interactive reports and dashboards using Power BI or Excel. Power BI also supports report and dashboard creation and consumption using Power BI Desktop or Excel. Synapse Analytics Studio does not have a native visualization service but can integrate with Power BI or other third-party tools.

- Data sharing: Fabric allows users to share their data and insights with others using the Fabric web portal or mobile app. Users can also embed their reports and dashboards into other applications using the Fabric Embedded service. Power BI also supports data sharing using the Power BI web portal or mobile app. Users can also embed their reports and dashboards into other applications using the Power BI Embedded service. Synapse Analytics Studio does not have a native data sharing service but can use Azure Active Directory or other mechanisms for access control.

In summary, Microsoft Fabric is a comprehensive analytics platform that covers all aspects of the data lifecycle and provides a unified experience for different roles and scenarios. Power BI is a business intelligence tool that focuses on data visualization and advanced analytics. Synapse Analytics Studio is a web-based interface that connects various Azure data services and enables users to perform diverse data tasks using a unified workspace.

Depending on your needs and preferences, you might choose one of these products or use them together to achieve your analytics goals. To learn more about each product and how they compare, you can visit their official websites or read the following resources: